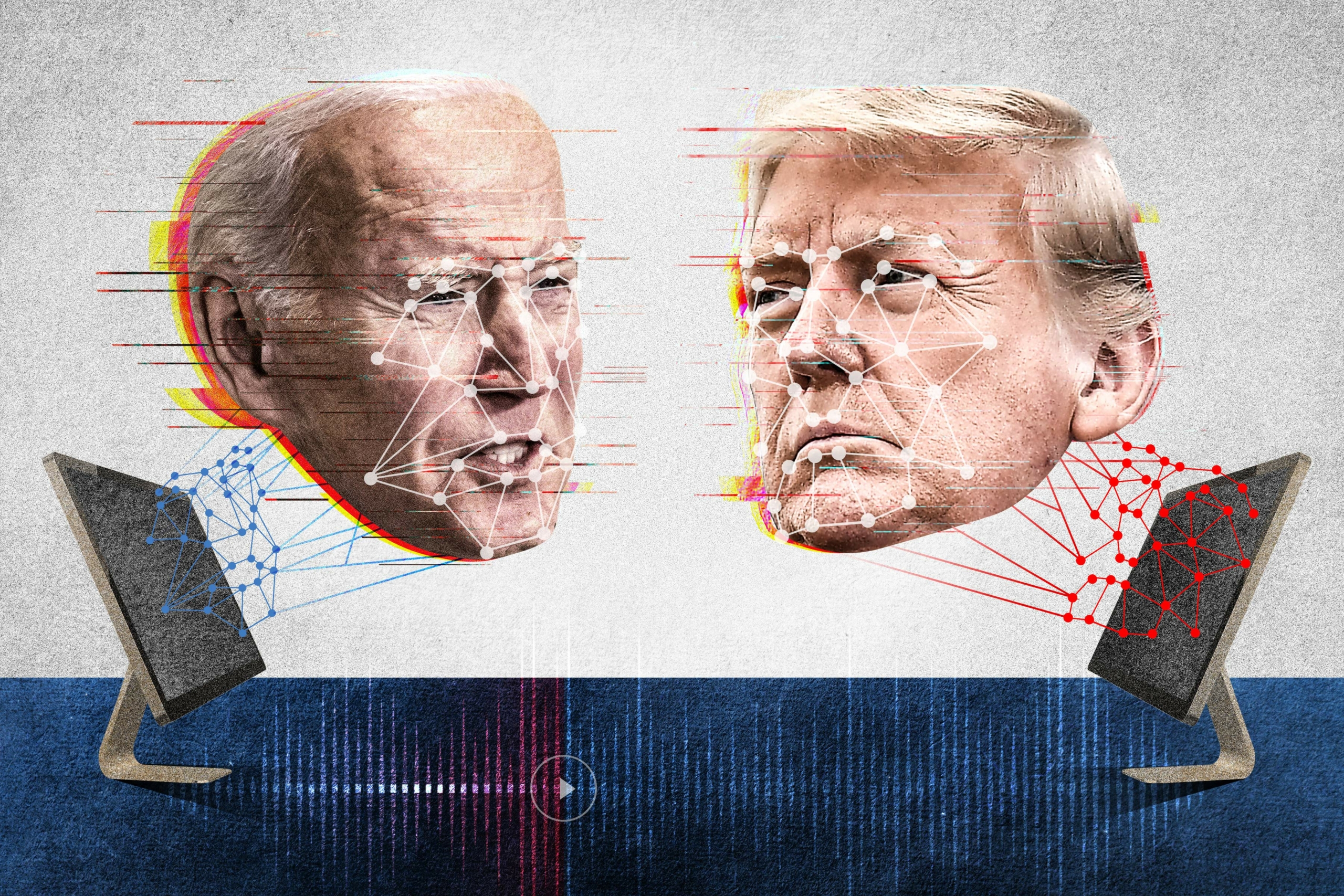

Trí tuệ nhân tạo hiện đang phát triển đến một mức mà từ các công cụ có thể truy cập rộng rãi, người ta có thể tạo ra các sản phẩm rất giống như thật — hình ảnh, âm thanh, và ngày càng nhiều các chuỗi video hoàn toàn do AI tạo ra.

Khi ngành này đang có những bước tiến nhảy vọt và con mắt người thường khó lòng phân biệt được đâu là thật giả, thì một số chuyên gia và doanh nhân đã nỗ lực nghĩ ra giải pháp.

Theo nhận định của một số chuyên gia mà The Epoch Times tham vấn, không gian kỹ thuật số đang ngày càng trở nên nguy hiểm.

Các sản phẩm làm giả chất lượng cao đã được tạo ra một cách nhanh chóng và dễ dàng. Các dịch vụ xác minh đã xuất hiện, sử dụng AI để phát hiện AI. Tuy nhiên, theo tiến trình này, thì sẽ có một cuộc chạy đua vũ trang giữa các công cụ sáng tạo sử dụng AI và các công cụ phát hiện AI, từ đó dẫn đến những thứ giả mạo ngày càng tinh vi hơn.

Kết quả sẽ là một thực tế ảo trong đó người dùng phần lớn mất khả năng phân biệt được thật và giả khi nhìn vào nội dung. Càng ngày, họ càng cần phải dựa vào các dịch vụ xác minh của bên thứ ba hoặc các nguồn thông tin đã tạo dựng được độ tin cậy vững chắc.

Vấn đề này có thể sẽ thu hút sự chú ý trong mùa bầu cử sắp tới trong bối cảnh ngày càng có nhiều lo ngại về tính xác thực của các thông tin chính trị.

Sức mạnh của video

AI tạo sinh đã được cải thiện với tốc độ nhảy vọt vào năm ngoái (2023), từ sự tinh xảo một cách đáng ngạc nhiên đến giống như thật một cách đáng sợ.

Ông Anatoly Kvitnitsky, nhà sáng lập kiêm giám đốc điều hành của dịch vụ phát hiện trí tuệ nhân tạo AI or Not cho biết rằng: “Chúng tôi đã thấy từ đầu năm 2023 đến cuối năm 2023, các hình ảnh có thể vượt qua bài kiểm tra bằng mắt người.”

“Dự đoán của chúng tôi là vào năm 2024 video cũng sẽ đạt đến mức như vậy.”

Ông Robert Marks, giáo sư khoa học máy điện toán tại Đại học Baylor, người đã đóng góp đáng kể cho lĩnh vực học máy, cho biết video giống như thật do AI tạo ra là “hoàn toàn nằm trong tầm tay của chúng ta.”

Ông nói với The Epoch Times rằng: “Trong tương lai, quý vị có thể làm những video đó từ con số 0 và chúng sẽ thực sự rất thật.”

Một số chuyên gia cho biết rằng thông tin giả mạo, dù có mang tính chính trị hay không, không phải là một hiện tượng mới lạ và từ lâu người ta đã có thể tạo dựng ra hình ảnh.

“Những thứ giả mạo đã tồn tại từ lâu lắm rồi … Chỉ là bây giờ chúng ta đã có một cách tạo ra chúng một cách tự động,” ông Marks nói.

Tuy nhiên, việc sản xuất các cảnh quay video giả luôn phức tạp và tiêu tốn nhiều nguồn lực. Thông thường, các trò lừa bịp bằng video liên quan đến việc chỉnh sửa các cảnh quay thực.

Theo ông John Maly, một kỹ sư máy điện toán và là luật sư về sở hữu trí tuệ, người đã nghiên cứu sâu về vấn đề sử dụng và lạm dụng AI, thì khả năng video giống thật được tạo ra từ con số 0 gây nguy hiểm ở một cấp độ mới.

Ông nói với The Epoch Times rằng: “Điều nguy hiểm của một video là nó có sức ảnh hưởng lớn hơn nhiều.

Cũng giống như trong các cuộc bầu cử trước đây, nếu có một “hồ sơ” xuất hiện với những lời cáo buộc về một ứng cử viên, thì “người bình thường sẽ không đọc hồ sơ đó,” ông Maly nói. Hầu hết mọi người có lẽ sẽ tìm hiểu nội dung chính của những cáo buộc đó thông qua bộ lọc của kênh truyền thông mà họ ưa thích, miễn là kênh truyền thông đó chọn đưa tin đó ngay từ đầu.

Nhưng video thì khác, ông nói.

Ông Maly cho hay: “Nếu có một đoạn video dài 30 giây quay cảnh ai đó sử dụng những lời lẽ miệt thị về chủng tộc hoặc tương tự như thế, điều đó sẽ có tác động ngay lập tức đến mọi người.”

“Và tôi nghĩ rằng tính tức thời sẽ là điều khiến thứ này thực sự trở thành một công cụ nguy hiểm hơn những công cụ khác.”

Ông nói, AI sẽ mở ra cơ hội tiếp cận các công cụ tạo ra thông tin giả mạnh mẽ cho các nhóm và cá nhân nằm ở phạm vi quá xa để có được các nguồn lực cần thiết trước đây để làm được những việc đó.

Ông Maly nói: “Các nhà hoạt động có thể kết hợp những thứ này lại với nhau và làm rò rỉ chúng và khiến chúng được lan truyền mà không phải bỏ ra chi phí tốn kém.”

Ông nói, AI cũng có thể tăng cường tính bí mật của các hoạt động đưa thông tin giả.

Chẳng hạn, nếu ai đó tổ chức một sự kiện giả mạo, nguy cơ bị lộ sẽ tăng lên khi càng có nhiều người tham gia vào việc này. Việc tạo ra toàn bộ kịch bản bằng kỹ thuật số sẽ làm giảm đáng kể số lượng người biết được kế hoạch này.

Ông Maly nói rằng: “Một người có thể viết kịch bản và tạo ra toàn bộ một video deepfake (*) và chỉ người đó mới biết họ đã tạo ra nó, và điều đó khiến việc truy tìm sự thật trở nên khó khăn hơn nhiều.”

Thời gian để phát triển chín muồi

Cho đến nay, AI đã được sử dụng thành công để biên tập video, chẳng hạn như thêm hoặc bớt vật thể hoặc chỉnh sửa khuôn mặt của một người trong video. Một số công cụ gần đây nhất cho phép người ta tạo ra các đoạn video giả hoàn toàn, mặc dù hiện tại các video kiểu như vậy chỉ được tạo ra với độ dài giới hạn chỉ được vài giây, và với động tác đơn giản, chẳng hạn như tạo ra video về một người đang quay đầu lại hoặc đi xuống phố.

Trong những tháng tới, những khả năng này dự kiến sẽ được cải thiện đáng kể.

Ông Kvitnitsky nói với The Epoch Times: “Điều này xuất hiện vừa đúng lúc để tạo ra thông tin sai lệch về chính trị khi chúng ta sắp sửa tập trung cao độ vào mùa bầu cử của quốc gia.”

Ông Marks không đi xa tới mức dự đoán rằng người ta sẽ tạo ra được video AI hoàn toàn giống như thật vào Ngày bầu cử, nhưng ông không loại trừ khả năng này.

“Điều gì sẽ xảy ra vào tháng Mười tới? Tôi không biết. Nhưng sự tăng tốc của trí tuệ nhân tạo thật đáng kinh ngạc”, ông nói.

Ông Marks dự đoán rằng nếu công nghệ này được sử dụng để tác động đến cuộc bầu cử, thì nó sẽ được căn vào đúng thời điểm để trở thành một “điều bất ngờ của tháng Mười” nhằm gạt đi cơ hội trong chớp mắt để lật tẩy công nghệ này trước khi cuộc bầu cử bắt đầu.

“Bây giờ, chúng ta có các công cụ để làm ra những điều bất ngờ trong tháng Mười với độ tinh vi cao hơn nhiều so với trước đây,” ông nói, và lưu ý rằng” sẽ khó khăn hơn để đối phó.”

Ông Maly dự đoán rằng công nghệ video AI giống như thật vẫn còn phải mất từ hai đến ba năm nữa để hoàn thiện.

“Tôi không nghĩ điều đó sẽ xảy ra trong năm tới, nhưng một lần nữa, tôi nghĩ chúng ta nhận ra rằng cách mà điều đó có thể xảy ra là những tổ chức giàu có nhất—tức là những tác nhân trong chính phủ từ các quốc gia thuộc thế giới thứ nhất—có lẽ sẽ trở thành một trong những người đầu tiên cố gắng cầm cố tài sản vào một công nghệ deepfake không thể bị phát hiện mà sẽ bị phát hiện muộn hơn nhiều về sau,” ông nói.

Phát hiện AI

Bất chấp những tiến bộ của công nghệ này, cho đến gần đây, người ta vẫn có thể phát hiện ra nội dung do AI tạo ra mà chẳng cần tốn nhiều công sức. Giọng nói giả mạo phát ra âm điệu không tự nhiên, đặc biệt là khi cố gắng bắt chước cảm xúc; hình dáng người trong hình ảnh được giả lập lộ ra những đường nét cơ thể không tự nhiên, chẳng hạn như thiếu hoặc thừa các ngón chân hoặc tay.

Tuy nhiên, trong vài tháng qua, những thiếu sót này đã được giảm thiểu đáng kể. Công cụ tạo âm thanh bằng AI giờ đây có thể nói bằng giọng của người thật một cách sống động, thậm chí là có thể hiện cảm xúc; hình ảnh AI hiện nay cho ra những hình ảnh về con người có kết cấu da tự nhiên và đường nét cơ thể chuẩn xác.

Vẫn còn những khiếm khuyết đáng chú ý, đặc biệt là ở những cảnh phức tạp hơn với nhiều người trong khung hình. AI dường như vẫn đang gặp khó khăn với chữ viết ở cảnh nền đằng sau. Ví dụ: biển hiệu mặt tiền cửa hàng ở nền phía sau thường hiển thị những dòng chữ vô nghĩa hoặc lộn xộn.

Ông Kvitnitsky nói: “Tuy nhiên, nếu không có những ‘điểm mấu chốt’ đó thì việc phát hiện sẽ thực sự khó khăn—đặc biệt là ở những hình ảnh chất lượng cao hơn, như ở những mô hình mới hơn.”

Ông Marks nói: “Trong nhiều trường hợp, chúng ta không thể phát hiện được bằng mắt thường.”

Trong những năm gần đây, một số công ty đã phát triển các công cụ sử dụng AI để phát hiện nội dung do AI tạo ra.

AI or Not của ông Kvitnitsky là một trong số những công ty đó.

“Chúng tôi đã đào tạo mô hình của mình trên hàng triệu hình ảnh, cả hình ảnh thực và do AI tạo ra. … Chúng tôi đã làm điều tương tự với âm thanh,” ông ấy nói.

Ông Kvitnitsky nói rằng “luôn có những dấu vết giả tạo mà mỗi mô hình AI tương ứng để lại”—một “sự kết hợp của các điểm ảnh” hoặc các mẫu bước sóng dưới một giây trong một tệp âm thanh mà mắt hoặc tai con người không thể nhận biết được.

Ông nói: “Mức độ chi tiết đó là cần thiết.”

Ông Kvitnitsky cho biết, trang web AI or Not không lưu trữ các tệp hình ảnh và âm thanh mà công cụ này kiểm tra và do đó không thể đưa ra số liệu thống kê tổng thể về độ tin cậy của công cụ này. Ông ấy có thông tin từ một số khách hàng của mình, những người cho biết rằng độ tin cậy rơi vào khoảng 90%.

The Epoch Times đã thử nghiệm công cụ này với sự kết hợp của khoảng 20 bức ảnh thật và hình ảnh do AI tạo ra. Hầu hết các bức ảnh thật đều chụp người, theo phong cách chân dung hoặc ảnh báo chí, và đã được chỉnh sửa về ánh sáng, độ tương phản, và tông màu. Các bức ảnh AI đều là ảnh chụp người theo phong cách trực diện, ảnh tự chụp, hoặc ảnh chân dung, do Midjourney V6 tạo ra. Midjourney V6 là một phiên bản mới phát hành của một công cụ tạo hình ảnh AI phổ biến, nhận được nhiều đánh giá khen ngợi vì sự chân thực. AI or Not đã xác định được chính xác tất cả các hình ảnh do AI tạo ra nhưng đánh dấu nhầm một trong những bức ảnh thật là có thể do AI tạo ra.

Vấn đề về xác định sai — nhầm lẫn nội dung do con người tạo ra với nội dung giả mạo — là một trong những lý do khiến ông Marks nghi ngờ công cụ phát hiện AI có thể là một “cách hiệu quả” để đối phó với deepfake. Ông nói rằng nếu những công cụ này được sử dụng để xác định nội dung giả mạo, và nếu như nội dung đó bị gỡ xuống và người dùng bị phạt vì đăng nội dung đó, thì có thể nhiều người sẽ bị phạt oan.

Ông Marks cho biết: “Không có kỹ thuật phát hiện nào có hiệu quả 100%.”

YouTube thuộc sở hữu của Alphabet đã thông báo rằng họ dự định đưa ra các quy định mới yêu cầu người dùng tự gắn nhãn cho các video có chứa “tài liệu bị thay đổi hoặc làm giả giống như thật,” chẳng hạn như “một video do AI tạo ra miêu tả một sự kiện chưa từng xảy ra giống như thật, hoặc nội dung cho thấy ai đó đang nói hoặc làm điều gì đó mà họ không thực sự làm.”

Thông báo hôm 14/11/2023 nêu rõ: “Những người sáng tạo [nội dung] liên tục chọn không tiết lộ thông tin này có thể bị xóa nội dung, bị đình chỉ khỏi Chương trình Đối tác YouTube, hoặc chịu các hình phạt khác.”

Nhưng khi được The Epoch Times hỏi, thì phát ngôn viên của công ty này đã không cho biết phương pháp nào sẽ được sử dụng để xác định nội dung nào do AI tạo ra và nội dung nào không.

Ông Maly bày tỏ lo ngại rằng một quy trình như vậy rốt cuộc sẽ không rõ ràng và chỉ mang tính một chiều.

“Nếu quý vị đang làm việc với bất cứ thứ gì như Facebook, thì thực sự không có gì đáng kể về quy trình khiếu nại. Quý vị nhấn một nút khiến quý vị cảm thấy như mình đã khiếu nại, nhưng không có ai để quý vị có thể nói chuyện. Quý vị thực sự không thể nộp đơn khiếu nại,” ông nói.

Facebook thuộc sở hữu của Meta đã không phúc đáp một yêu cầu cung cấp thông tin về cách công ty này dự định giải quyết nội dung do AI tạo ra.

‘Cuộc chạy đua vũ trang’

Ông Marks cho biết có một nhược điểm khác của công cụ phát hiện AI: Những công cụ này có thể bị đánh lừa.

Ông đưa ra một bài nghiên cứu năm 2022 có tên “Tạo ra, Sử dụng, Lạm dụng, và Phát hiện Deep Fake” của ông Hany Farid, một giáo sư khoa học máy điện toán tại Đại học California – Berkeley. Bài nghiên cứu mô tả một phương pháp gọi là “nhiễu loạn bất lợi,” trong đó một bức ảnh do AI tạo ra được phủ lên một dạng nhiễu mà mắt người không nhận ra được nhưng đã đánh lừa được công cụ phát hiện, khiến nó cho rằng bức ảnh là thật.

The Epoch Times đã thử nghiệm khái niệm này bằng cách liên tục chỉnh sửa một số hình ảnh trong số những hình ảnh đặc biệt trông có vẻ chân thực do AI Midjourney V6 tạo ra. Công cụ AI or Not lúc đầu đã gắn nhãn chính xác cho chúng là có thể là giả mạo, nhưng sau nhiều lần chỉnh sửa, chẳng hạn như thêm và giảm nhiễu, thay đổi kích thước, làm sắc nét, và liên tục điều chỉnh độ phơi sáng và độ tương phản, thì hầu hết các hình ảnh đều được chuyển qua là “có thể là do con người tạo ra,” mặc dù những bức ảnh này khiến cho công cụ đưa ra cảnh báo “chất lượng hình ảnh thấp.”

Trong một phúc đáp qua thư điện tử, ông Kvitnitsky cho biết cảnh báo xuất hiện khi công cụ này phát hiện các thay đổi về ánh sáng, định dạng tệp, và “các kỹ thuật xáo trộn khác.”

Ông nói: “Mục đích là cung cấp một dấu hiệu nếu như chúng ta cho rằng hình ảnh này cần được xem xét thêm.”

Vấn đề là tất cả các bức ảnh thật mà The Epoch Times sử dụng để kiểm tra công cụ này cũng gây ra cảnh báo chất lượng thấp.

Ông Kvitnitsky cho biết những khách hàng có gói ghi danh “cao cấp” của ông được cung cấp không chỉ kết quả nhị phân “có thể là AI”/“có thể là con người” mà còn cả “điểm tin cậy” cho mỗi kết quả.

Ông nhấn mạnh rằng nhóm của ông đang liên tục cải tiến công cụ này, vốn hiện đang trong quá trình đào tạo để phát hiện các hình ảnh do Midjourney V6 mới tạo ra.

Ông Kvitnitsky nói: “Chúng tôi tìm ra các trường hợp hóc búa, chúng tôi xác định chúng trong nhóm của mình, và sau đó tìm ra cách để bảo đảm chúng tôi sẽ phát hiện ra chúng.”

Tuy nhiên, ông Marks chỉ ra rằng quá trình cải tiến diễn ra theo cả hai chiều.

“Điều đó giống như chạy đua vũ trang. Quý vị nghĩ ra một cách làm giả video, ai đó nghĩ ra cách phát hiện ra video giả này. Nhưng rồi phía bên kia tìm hiểu cách phát hiện ra video giả, và họ tìm ra cách né tránh điều đó,” ông nói.

Cuối cùng, những nội dung giả “sẽ đạt đến mức rất khó phát hiện,” ông Marks dự đoán.

Ông Kvitnitsky thừa nhận rằng tình hình này giống như trò chơi đuổi bắt mà các nhà phát triển an ninh mạng chơi với tin tặc.

“Chúng tôi đang cố gắng đi trước trong việc này, nhưng vâng, chính xác là như vậy. Đây là một giai đoạn mới về an ninh mạng,” ông nói, lưu ý rằng một số khách hàng lớn nhất của ông hoạt động trong lĩnh vực an ninh mạng.

Ngoài ra, có một số trở ngại đáng chú ý khi chơi trò chơi đuổi bắt trong thế giới thông tin không hoàn hảo, ông Maly cho biết.

Ông nói rằng có một điều, các mô hình AI tạo sinh không nhất thiết phát triển theo từng bước.

“Cứ hai hoặc ba năm, họ lại cho dừng hoàn toàn những mô hình đó và bắt đầu lại từ đầu. Là người dùng, quý vị có thể sẽ không nhận ra điều đó vì họ vẫn dùng giao diện như thế và họ vẫn dùng cái tên như thế cho sản phẩm đó,” ông Maly nói.

Và một mô hình mới đồng nghĩa với việc công cụ phát hiện cần được đào tạo lại.

Ngoài ra, video giả mạo dạng dài hơn có thể khá phức tạp và có thể được tạo ra bởi nhiều công cụ khác nhau mà mỗi công cụ đều để lại dấu hiệu của mình, vốn sau đó được kết hợp với nhau trong sản phẩm cuối cùng.

Ông Maly nói: “Chúng ta càng kết hợp nhiều thứ thành một sản phẩm cao cấp hơn thì càng khó phát hiện ra nguồn gốc của các thành phần khác nhau.”

Các nội dung giả cũng sẽ dễ gây bối rối hơn khi mô tả các sự kiện hỗn loạn như chiến tranh hoặc bạo loạn.

“Có thể chúng có góc máy quay lạ, có thể chúng bị mờ, có thể có nước hoặc bụi bẩn trên máy ảnh,” ông nói.

“Vì vậy, tôi nghĩ có lẽ sẽ có thể chấp nhận được nếu có sự xáo trộn trong loại cảnh quay đó vì chúng ta đã quen với việc có chất lượng không hoàn hảo đó.”

Chữ ký số

Một số công ty và tổ chức phi chính phủ đã đề nghị loại bỏ các deepfake thông qua “chữ ký mật mã.”

Ý tưởng là phần mềm mà tạo ra một nội dung sẽ lưu trữ vào đó một số thông tin được mã hóa, chẳng hạn như thời gian, địa điểm, và người sáng tạo ra nội dung đó. Sau đó, phiên bản mã được mã hóa sẽ được lưu trữ ở một vị trí đáng tin cậy nào đó. Sau đó có thể kiểm tra “xuất xứ” của nội dung.

“Các công ty nên phát triển các phương pháp hiệu quả để gắn nhãn nội dung do AI tạo ra, bao gồm sử dụng một chữ ký mật mã và phối hợp với xã hội dân sự để đề ra tiêu chuẩn cho cách ngành này ghi lại nguồn gốc của nội dung cụ thể,” Freedom House, một nhóm vận động nhân quyền, nêu trong những lời khuyên về chính sách AI hồi năm 2023 của nhóm. Nhóm này cũng gợi ý rằng các công ty nên “đầu tư vào việc phát triển phần mềm để phát hiện nội dung do AI tạo ra.”

Ông Farid cho biết trong bài nghiên cứu năm 2022 của mình: “Ưu điểm của các phương pháp tiếp cận dựa trên xuất xứ này là các phương pháp này có thể áp dụng cho việc tạo và tiêu thụ nội dung trên quy mô Internet.”

“Điều bất lợi là các phương pháp này sẽ yêu cầu sự chấp thuận rộng rãi trong [các cộng đồng của] những người sáng tạo, nhà xuất bản, và các đại công ty truyền thông xã hội.”

Tuy nhiên, sự chấp thuận rộng rãi đó dường như sẽ không xảy ra. Hệ thống này có một vấn đề liên quan đến quyền riêng tư. Một xã hội tự do không hẳn sẽ muốn tạo thuận tiện cho chính phủ dễ dàng truy tìm nguồn gốc của mọi thông tin, đặc biệt khi liên quan đến phát ngôn chính trị.

Do đó, những người ủng hộ hệ thống này đề nghị một phương án khác cho phép người sáng tạo nội dung giới hạn thông tin “xuất xứ” mà họ muốn chia sẻ. Tuy nhiên, khi đó, hệ thống sẽ không chứng minh được tính chính xác của thông tin mà chỉ biết rằng đó là thông tin mà người sáng tạo nội dung muốn chia sẻ.

Tác động rộng hơn

Sự ra đời của các sản phẩm giống như thật mà AI tạo ra có thể định hình lại văn hóa trực tuyến và làm xói mòn niềm tin vào thông tin kỹ thuật số vốn đã thiếu tính xác thực ở ngoài đời thực.

Ông Marks nói: “Việc phân biệt sự thật giờ đây sẽ khó khăn hơn nhiều so với trước kia.”

Ngay cả khi không có bất kỳ sự ngạc nhiên nào về deepfake, sự tồn tại đơn thuần của các công cụ deepfake đã tạo ra thứ mà ông Farid gọi là “lợi ích của kẻ nói dối” — khi đó người ta có thể cố gắng cho rằng thông tin chân thực là giả mạo.

Ông cho rằng “có thể” “một số phiên bản của giải pháp dựa trên xuất xứ, cùng với các kế hoạch phát hiện… sẽ là cần thiết để giúp thiết lập lại niềm tin vào nội dung trực tuyến.”

Ông Kvitnitsky bày tỏ sự tin tưởng rằng công ty của ông sẽ giúp củng cố niềm tin đó.

Tuy nhiên, ông Maly nói rằng việc dựa vào AI để chống lại AI tất nhiên sẽ khiến người dùng nhường lại quyền kiểm soát việc nhận biết sự thật [cho AI].

“Đây dường như chính xác là hệ sinh thái xã hội mà chúng ta sắp tham gia: [Chúng tôi] không tin rằng AI không lừa dối chúng tôi, nhưng cách duy nhất để kiểm tra là sử dụng các AI khác mà chúng tôi không tạo ra,” ông nói trong một phúc đáp qua thư điện tử.

Ông Maly nói, điều này thậm chí có thể dẫn đến tình huống một số đại công ty công nghệ cung cấp cả công cụ sáng tạo nội dung bằng AI lẫn công cụ phát hiện AI, “kiểm soát cả hai bên của phương trình”.

Ông nói: “Không chắc có thể kiểm tra được các công cụ phát hiện này hay không.”

“Giả sử như AI là nguồn mở để có thể được kiểm tra, thì AI đó có thể bị phân tích và phá vỡ, vì vậy tôi đoán đó sẽ là một hệ sinh thái gồm các giải pháp khép kín, độc quyền, như chúng ta đã có với phần mềm chống virus — có những phần mềm diệt virus đáng tin cậy, nhưng chúng tôi vẫn sẽ đưa ra các giả thuyết về thực tiễn an ninh, và động cơ của nhà cung cấp của chúng tôi.”

Ông nói, điều quan trọng là mọi người phải tự học hỏi về chức năng và khả năng của AI.

“Bất kỳ ai muốn có hy vọng biết được sự thật đều phải có một mức độ hiểu biết nhất định về AI và theo dõi tin tức về AI, nếu không, việc tin tưởng vào dữ liệu do AI tạo ra sẽ gần giống như đặt cược cuộc sống của quý vị vào quả bóng số 8 ma thuật đồ chơi,” ông Maly nói. “Có thể nói rằng sự tự mãn luôn là kẻ thù của sự thật, nhưng cái giá phải trả của sự tự mãn đối với dư luận xã hội sắp trở nên nghiêm trọng hơn nhiều.”

Ông Marks gợi ý rằng mọi người sẽ cần “sử dụng một số công cụ cũ” để đánh giá tính xác thực của nội dung kỹ thuật số.

“Quý vị xem xét nguồn cung cấp thông tin, mức độ quan tâm của họ đối với việc quảng bá bài báo. … Có một số công cụ có thể được sử dụng để đánh giá sự thật. Chúng có hiệu quả 100% hay không? Không. Nhưng tôi nghĩ chúng vô cùng hữu ích,” ông nói.

“Đây không phải là một vấn đề với AI, đây là một vấn đề với vấn đề này. Lúc nào quý vị cũng bắt gặp thông tin giả. Và vấn đề của vấn đề này là mọi người đưa ra những thông tin giả mạo và quý vị phải tìm hiểu xem thông tin đó có đúng hay không.”